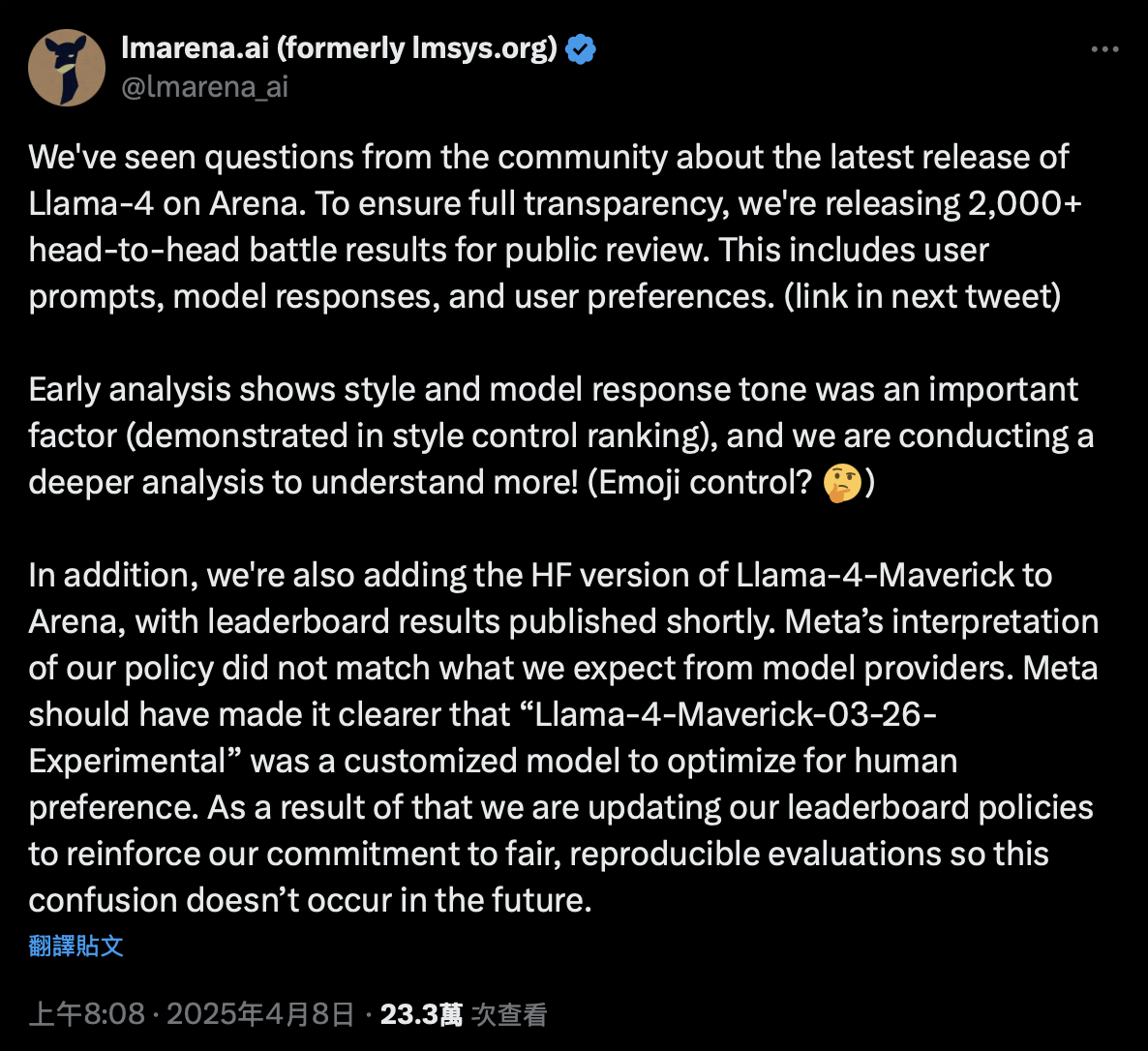

增加开放资源的大型骑行骑士4仍在发酵。 4月8日,聊天机器人体育馆(通常被称为“大型模型”),这是“大型语言模型的强大列表”,发表了一份具有罕见和严肃基调的声明。面对社区对排名新的Meta Model Llama 4的怀疑,官员说,超过2,000次实时演变的完整数据将透露2,000多个现场演出的命名:Meta应该更加清楚地命名。更清楚地表明,这应该更清楚,“'Llama-4-Maverick-03-26-实验'是一种定制的模型,已优化为人类偏好。我们正在更新排名策略,以防止这种混乱发生。 ”“元数据应该更清楚地表明,'Llama-4-Maverick-03-26-实验'是一种定制模型,被优化为人类偏好。我们正在更新排名策略,以避免再次发生这种混乱。 “照片/x这个语句不在这是一个澄清,也是对整个大型模型行业的唤醒呼吁。聊天机器人体育馆由加州大学伯克利分校发起,是当前大型模型评论中最有影响力的“真正的人盲测”排名。聊天机器人竞技场超过了许多领先的嘲弄,仅次于Gemini 2.5 Pro Pina Pinalack Google的Google,每个人的好奇心和期望自然都会引起。但是很快,社区发现此版本是未指定和自定义的“实验模型”,而不是元版开源的官方版本。因此,争议被打破了:是否认为“短刷”?聊天机器人竞技场是否用作营销工具?为什么这样的元运行?扩展全文

更糟糕的是,骆驼4不好,几乎是在一些未正式展示的专业基准下。许多尝试过它的最早的用户也表达了他们在诸如reddit和X等社交平台上的失败。有人提到你在其帖子中,不愉快的美洲驼编程技能,并指导:

“考虑到402b参数量中的Llama-4-Maverickpara,为什么我不使用DeepSeek-V3-0324直接使用?或QWEN-QWQ-32B QWEN-QWQ-32B可能更合适,即使性能相似,它的参数只有32B。”

“考虑到Llama-4-Maverick具有402B参数卷,为什么我不直接使用DeepSeek-V3-0324?或QWEN-QWQ-32B更合适 - 即使性能相似,它具有32B参数的体积。”

图片/reddit

这使人们想知道为什么开源营地完全期望的元元素逐渐以骆驼2和骆驼3的形式确立了声誉,这只会远离美洲驼4?

从亮点到碰撞的房屋,令人惊叹的72小时

早在4月5日,梅塔(Meta)在其官方博客上发表了一篇文章“ Llama 4 Herd:本机多模式AI创新的新时代的开始”,正式宣布,Llama 4系列模型是Komnidad的开放资源。

在这次,Meta发布了最新一代模型的三个版本:Llama 4 Scout,Llama 4 Maverick和“教师模型” Llama 4 Beymoth,他们仍在培训中,所有这些都在第一次接受了混合专家(MOE)的建筑。

图片/元

MMANTSTREAM和最受欢迎的Maverick版本是170亿个活动参数模型,具有128个“专家”(总参数为4000亿)。 Meta将其描述为“它类型的最佳多模型”,强调它在许多方面都比Gemini 2.0和GPT-4O还要多,并且比DeepSeek 3.1更具竞争力,并且在编码和推理方面更具竞争力。

但是,在Llama 4发布后不久,事情很快就偏离了Meta的期望。

在社区层面上,第一批用户不购买Llama Performance 4。在许多试验中,尤其是在SESA中,需要代码功能和严格的逻辑推理,Llama 4 Performance无法在GPT和DeepSeek之外履行其性能。以及由Aider Chat提供的Polyglot编程测试,Maverick版本仅为16%,在排名末尾。

即使它是较小的开源型号,例如Google Gamma,它不仅与其庞大的参数大小完全不一致。许多开发人员感到惊讶,也与官方宣传形成了鲜明的对比。

照片/聊天机器人竞技场

由于拒绝名声是否认的,因此合规性更为严重 - 美洲驼4是否使用公共测试集进行培训?聊天机器人竞技场是针对一般基准测试的吗?这些疑问正在传播并迅速庆祝技术界,其中包括聊天机器人体育馆的说法,即使他不使用“作弊”之类的词,但线之间的语气也很艰难且不满意。

尤其是在中国移民社区“一公顷和三部分土地”中,“元员工”说提交辞职,并要求将其姓名删除。模型)。

但是,大都会一个团队很快就澄清了,Meta Genai的成员举行了“训练后”说:

“在过去的两天中,我已经听了所有评论(例如编码,创意写作和其他应该得到改善的缺陷),并希望在下一版本中改进。但是,我们还没有做过过度膨胀的急性尚未恢复积分。

图片/Licheng Yu

公共信息显示,列竹(Yu Licheng)以学士学位毕业于上海大道大学,并于2014年获得了佐治亚理工学院和上海jiotong大学的双重硕士学位,并获得了博士学位。 2019年,北卡罗来纳大学教堂山分校的计算机科学专业。

同时,Meta Genai副总裁Ahmad Al-Dahle在X平台上也很清楚“ Meta在测试集中没有实践Llama 4”。响应Llama-4-Maverick-03-26-实验性,Meta在回应户外批评之后也选择发布该资源的开放版本。

图片/X

但是,这些答案都无法避免:雅拉4的真正能力。

作为将“对OpenAI最有前途的挑战”带到开源营的标准,Llama 4最初带来了开发商和工业期望。但是现在,它已经从“亮点”到发行后的一周内的“信任危机”,在犬儒主义竞争中成为罕见的声誉“滑铁卢”。

DeepSeek速度开放资源,Meta被迫站立

如果您只是看表面,那么目前将吊销Llama 4的声誉,并且似乎充满了巨大的紧张局势。未知员工宣布,为了实现内部截止日期,Meta Requ的高级管理人员请注意,主要的测试集与“训练后”混合在一起,仅仅是为了看到“结果”。甚至有谣言说,负责人工智能副总统乔尔·皮诺(Joelle Pineau)因反对这项技能而离开了办公室。

但是,从当前信息到公众,这些陈述无法忍受调查。至于使用测试集的训练后问题,实际上澄清了先前的响应。乔尔·皮诺(Joelle Pineau)的拆除发生在发布前两天,但她不对生成的AI团队负责,但领导了Meta基本AI研究(公平)研究部门,与Llama Project 4没有直接联系。

乔尔·皮诺(Joelle Pineau),几天前离开了她的工作,图片/元

在消除了公众意见的噪音之后,出现了真正的问题。老实说,《问题骆驼4》不是关于欺诈,而是要在竞争开放资源的竞争中停滞不前。

在过去的两年中,元数据逐渐建立了一个“领先和可靠的” UNDELlama 2和Llama 3的开源模型市场的支持。然而,到Llama 4,情况发生了巨大变化。 DeepSeek V3/R1的发布扭转了开放资源和封闭资源模型之间的差距,并大大加快了开放资源的发展。

它使Llama最初是“开源负责人”,承受着更大的压力。

尽管我们认为以前的许多启示无法忍受调查,但事实是:Llama 4的截止日期。从以下事实可以看出,Llama 4庞然大物仍在实践中,并且在扩大参数规模和建筑的复杂性(MOE)的同时,Llama 4可能不会留下足够的测试和改进的时间,从而导致发行后的性能不稳定。

图片/元

另外,元无法控制运动的变形。 Llama-4-Maverick-03-26-实验对话模式本身的优化是可以理解的,但是“首次启动”聊天机器人竞技场的目的是向所有人致敬。我们不知道这个特殊版本的牺牲是什么?回到Sohu看看更多

增加开放资源的大型骑行骑士4仍在发酵。 4月8日,聊天机器人体育馆(通常被称为“大型模型”),这是“大型语言模型的强大列表”,发表了一份具有罕见和严肃基调的声明。面对社区对排名新的Meta Model Llama 4的怀疑,官员说,超过2,000次实时演变的完整数据将透露2,000多个现场演出的命名:Meta应该更加清楚地命名。更清楚地表明,这应该更清楚,“'Llama-4-Maverick-03-26-实验'是一种定制的模型,已优化为人类偏好。我们正在更新排名策略,以防止这种混乱发生。 ”“元数据应该更清楚地表明,'Llama-4-Maverick-03-26-实验'是一种定制模型,被优化为人类偏好。我们正在更新排名策略,以避免再次发生这种混乱。 “照片/x这个语句不在这是一个澄清,也是对整个大型模型行业的唤醒呼吁。聊天机器人体育馆由加州大学伯克利分校发起,是当前大型模型评论中最有影响力的“真正的人盲测”排名。聊天机器人竞技场超过了许多领先的嘲弄,仅次于Gemini 2.5 Pro Pina Pinalack Google的Google,每个人的好奇心和期望自然都会引起。但是很快,社区发现此版本是未指定和自定义的“实验模型”,而不是元版开源的官方版本。因此,争议被打破了:是否认为“短刷”?聊天机器人竞技场是否用作营销工具?为什么这样的元运行?扩展全文

更糟糕的是,骆驼4不好,几乎是在一些未正式展示的专业基准下。许多尝试过它的最早的用户也表达了他们在诸如reddit和X等社交平台上的失败。有人提到你在其帖子中,不愉快的美洲驼编程技能,并指导:

“考虑到402b参数量中的Llama-4-Maverickpara,为什么我不使用DeepSeek-V3-0324直接使用?或QWEN-QWQ-32B QWEN-QWQ-32B可能更合适,即使性能相似,它的参数只有32B。”

“考虑到Llama-4-Maverick具有402B参数卷,为什么我不直接使用DeepSeek-V3-0324?或QWEN-QWQ-32B更合适 - 即使性能相似,它具有32B参数的体积。”

图片/reddit

这使人们想知道为什么开源营地完全期望的元元素逐渐以骆驼2和骆驼3的形式确立了声誉,这只会远离美洲驼4?

从亮点到碰撞的房屋,令人惊叹的72小时

早在4月5日,梅塔(Meta)在其官方博客上发表了一篇文章“ Llama 4 Herd:本机多模式AI创新的新时代的开始”,正式宣布,Llama 4系列模型是Komnidad的开放资源。

在这次,Meta发布了最新一代模型的三个版本:Llama 4 Scout,Llama 4 Maverick和“教师模型” Llama 4 Beymoth,他们仍在培训中,所有这些都在第一次接受了混合专家(MOE)的建筑。

图片/元

MMANTSTREAM和最受欢迎的Maverick版本是170亿个活动参数模型,具有128个“专家”(总参数为4000亿)。 Meta将其描述为“它类型的最佳多模型”,强调它在许多方面都比Gemini 2.0和GPT-4O还要多,并且比DeepSeek 3.1更具竞争力,并且在编码和推理方面更具竞争力。

但是,在Llama 4发布后不久,事情很快就偏离了Meta的期望。

在社区层面上,第一批用户不购买Llama Performance 4。在许多试验中,尤其是在SESA中,需要代码功能和严格的逻辑推理,Llama 4 Performance无法在GPT和DeepSeek之外履行其性能。以及由Aider Chat提供的Polyglot编程测试,Maverick版本仅为16%,在排名末尾。

即使它是较小的开源型号,例如Google Gamma,它不仅与其庞大的参数大小完全不一致。许多开发人员感到惊讶,也与官方宣传形成了鲜明的对比。

照片/聊天机器人竞技场

由于拒绝名声是否认的,因此合规性更为严重 - 美洲驼4是否使用公共测试集进行培训?聊天机器人竞技场是针对一般基准测试的吗?这些疑问正在传播并迅速庆祝技术界,其中包括聊天机器人体育馆的说法,即使他不使用“作弊”之类的词,但线之间的语气也很艰难且不满意。

尤其是在中国移民社区“一公顷和三部分土地”中,“元员工”说提交辞职,并要求将其姓名删除。模型)。

但是,大都会一个团队很快就澄清了,Meta Genai的成员举行了“训练后”说:

“在过去的两天中,我已经听了所有评论(例如编码,创意写作和其他应该得到改善的缺陷),并希望在下一版本中改进。但是,我们还没有做过过度膨胀的急性尚未恢复积分。

图片/Licheng Yu

公共信息显示,列竹(Yu Licheng)以学士学位毕业于上海大道大学,并于2014年获得了佐治亚理工学院和上海jiotong大学的双重硕士学位,并获得了博士学位。 2019年,北卡罗来纳大学教堂山分校的计算机科学专业。

同时,Meta Genai副总裁Ahmad Al-Dahle在X平台上也很清楚“ Meta在测试集中没有实践Llama 4”。响应Llama-4-Maverick-03-26-实验性,Meta在回应户外批评之后也选择发布该资源的开放版本。

图片/X

但是,这些答案都无法避免:雅拉4的真正能力。

作为将“对OpenAI最有前途的挑战”带到开源营的标准,Llama 4最初带来了开发商和工业期望。但是现在,它已经从“亮点”到发行后的一周内的“信任危机”,在犬儒主义竞争中成为罕见的声誉“滑铁卢”。

DeepSeek速度开放资源,Meta被迫站立

如果您只是看表面,那么目前将吊销Llama 4的声誉,并且似乎充满了巨大的紧张局势。未知员工宣布,为了实现内部截止日期,Meta Requ的高级管理人员请注意,主要的测试集与“训练后”混合在一起,仅仅是为了看到“结果”。甚至有谣言说,负责人工智能副总统乔尔·皮诺(Joelle Pineau)因反对这项技能而离开了办公室。

但是,从当前信息到公众,这些陈述无法忍受调查。至于使用测试集的训练后问题,实际上澄清了先前的响应。乔尔·皮诺(Joelle Pineau)的拆除发生在发布前两天,但她不对生成的AI团队负责,但领导了Meta基本AI研究(公平)研究部门,与Llama Project 4没有直接联系。

乔尔·皮诺(Joelle Pineau),几天前离开了她的工作,图片/元

在消除了公众意见的噪音之后,出现了真正的问题。老实说,《问题骆驼4》不是关于欺诈,而是要在竞争开放资源的竞争中停滞不前。

在过去的两年中,元数据逐渐建立了一个“领先和可靠的” UNDELlama 2和Llama 3的开源模型市场的支持。然而,到Llama 4,情况发生了巨大变化。 DeepSeek V3/R1的发布扭转了开放资源和封闭资源模型之间的差距,并大大加快了开放资源的发展。

它使Llama最初是“开源负责人”,承受着更大的压力。

尽管我们认为以前的许多启示无法忍受调查,但事实是:Llama 4的截止日期。从以下事实可以看出,Llama 4庞然大物仍在实践中,并且在扩大参数规模和建筑的复杂性(MOE)的同时,Llama 4可能不会留下足够的测试和改进的时间,从而导致发行后的性能不稳定。

图片/元

另外,元无法控制运动的变形。 Llama-4-Maverick-03-26-实验对话模式本身的优化是可以理解的,但是“首次启动”聊天机器人竞技场的目的是向所有人致敬。我们不知道这个特殊版本的牺牲是什么?回到Sohu看看更多

从亮点到倒塌的房屋,Meta Llama 4有一个可怕的72小时

2025-04-09